Suelo decirles a los alumnos de mis clases de filosofía de la ciencia que uno de los mayores debates científico-filosóficos del siglo XX casi nunca se les menciona con algún detalle a los estudiantes de filosofía (y hasta donde sé tampoco a los de ciencias). Me refiero al debate sobre la naturaleza de la realidad y los fundamentos de la teoría cuántica que se inició en 1927 en el Congreso Solvay de Bruselas y perdura hasta nuestros días.

Los dos grandes protagonistas del mismo fueron Albert Einstein y Niels Bohr, pero desde luego no fueron los únicos intervinientes. Al lado antirrealista, que era el de Bohr, se sumaron también Werner Heisenberg, Max Born y John von Neuman, entre otros, y en el lado realista que era el de Einstein, se situaron, aunque de forma más diversa, Erwin Schrödinger, Louis de Broglie, David Bohm, John Bell y Hugh Everett. Fue un debate que alcanzó en ocasiones una intensidad inusitada e incluso una sorprendente acritud y enconamiento, que llegó al extremo de arruinar algunas carreras prometedoras.

Su trascendencia cultural fue mucho mayor de lo que tiende a pensarse, y, si bien se mira, no se comprenden cabalmente algunos acontecimientos del siglo XX, no solo en el ámbito científico y filosófico, sin conocer sus entresijos.

Realistas versus antirrealistas: algo más que un simple debate científico

La teoría cuántica es la teoría científica mejor confirmada y más exitosa que tenemos. Casi toda la tecnología actual más relevante se basa en ella. Ha sido, además, desde sus comienzos intrigante para los filósofos y para los físicos con vocación teórica, porque plantea problemas de gran envergadura y profundidad, que sus creadores se tomaron muy en serio. Se dice que Bohr estuvo garabateando en su lecho de muerte una respuesta a la última objeción de Einstein, quien nunca aceptó que la teoría cuántica fuese una teoría acabada.

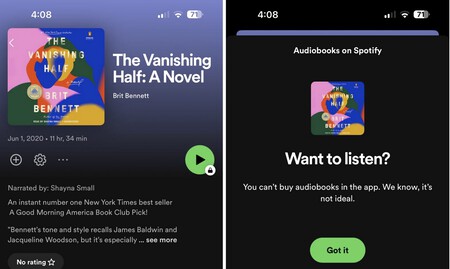

Congreso Solvay celebrado en 1927 En esencia, el debate filosófico sobre la "realidad" cuántica no es sino la continuación de un viejo debate sobre la forma más adecuada de entender las teorías científicas y su relación con el mundo que tratan de conocer. Hay dos posiciones básicas. Según los realistas, las teorías científicas tienen como objetivo averiguar, aunque sea siempre de forma falible, qué entidades y procesos hay en el mundo, qué propiedades tienen y por qué cambian de un modo definido. Esas entidades, procesos y propiedades existen en el mundo con independencia de cualquier observador.

Consideran, además, que las evidencias obtenidas mediante la observación y los experimentos pueden aportar elementos de juicio para aceptar la verdad (aproximada) de las teorías exitosas.

Los antirrealistas ven las cosas de otro modo. Consideran que el papel de las teorías científicas consiste en calcular, predecir y controlar una forma simple y fructífera las manifestaciones observables de la naturaleza (lo que los clásicos llamaban “salvar los fenómenos”). Las teorías son, pues, herramientas conceptuales para manejar el mundo y no deben interpretarse como guías ontológicas, es decir, no deben tomarse como un catálogo acerca del mobiliario del universo, y mucho menos en lo que se refiere a las entidades inobservables. La evidencia empírica sólo nos permite afirmar la adecuación empírica de la teoría, es decir, solo podemos afirmar que la teoría ha encajado bien hasta el momento con los fenómenos conocidos y, particularmente, que ha resultado efectiva en su capacidad de predicción.

La interpretación de Copenhague, el origen de la discordia

La teoría cuántica constituye un desafío para las posiciones realistas si la tomamos en la interpretación considerada como estándar, la interpretación de Copenhague, desarrollada fundamentalmente por Bohr, Heisenberg y Born. Una interpretación cuyo contenido preciso, sin embargo, sigue siendo objeto de controversia entre físicos e historiadores. De hecho, Bohr y Heisenberg discreparon en puntos importantes.

También en cuanto a sus planteamientos filosóficos. Bohr fue una especie de fenomenista kantiano, mientras que Heisenberg estuvo más cercano al positivismo. En lo que ambos coincidían era en su instrumentalismo.

Bohr, un tipo poco realista. Para empezar, en dicha interpretación la teoría no atribuye valores definidos a ciertas propiedades de los sistemas físicos que estudia (por ejemplo, la posición y la velocidad de un electrón) hasta tanto no hayan sido observados o medidos. Tales propiedades sólo adquieren un valor real en el proceso de medición, y siempre dentro del contexto de la completa situación experimental.

Por tanto, no tiene sentido hablar de ellas como si estuvieran definidas con independencia del acto de medición y este nos diera únicamente ese valor previo desconocido. Su “realidad”, el valor concreto de cada una de ellas, se adquiere precisamente en el conjunto del dispositivo experimental montado para observarlas. Antes de ese momento, el sistema cuántico evoluciona (de forma determinista) en una superposición de estados, es decir, en una combinación de todos los valores posibles para cada una de esas propiedades.

La evolución de este sistema es descrita por una ecuación propuesta por Schrödinger. En ella se describe la evolución en el tiempo de la función de onda Ψ, que a su vez es la representación del estado del sistema cuántico. Inmediatamente después de que Schrödinger la propusiera, Max Born proporcionó una interpretación probabilística de la función de onda. De acuerdo con Born, el cuadrado del valor absoluto de Ψ nos daría la probabilidad de obtener ciertos resultados en las mediciones. La función de onda no representaría, por tanto, ninguna onda real, sino que es, en definitiva, una herramienta para calcular la probabilidad de obtención de los resultados experimentales.

Veámoslo con un ejemplo. Los electrones tienen una propiedad conocida como spin o momento angular intrínseco, que puede tomar los valores de +1/2 y –1/2 (en un sentido laxo se puede decir que esto es algo así como si el electrón estuviera girando hacia la derecha o hacia la izquierda). Antes de que alguien lo observe, el electrón está un estado de “mezcla” o superposición de los dos valores; pero una vez que se mide el spin de ese electrón, el acto de medición hace que la función de onda “colapse” y solo se obtiene uno de los dos resultados posibles.

La reducción a un solo estado se conoce como el ‘colapso de la función de onda’. La transición instantánea, no regida ya por la ecuación de Schrödinger, de un sistema evolucionando de forma determinista en una superposición de estados a un sistema que adquiere de forma indeterminista uno de los estados posibles constituye ‘el problema de la medida’. El problema no es otro que el de explicar cómo y por qué se produce este extraño salto. ¿Qué es exactamente lo que cambia ¿Ha de implicar el proceso a un observador humano?

El gato de Schrödinger y la superposición de estados

Todos hemos oído hablar alguna vez del gato de Schrödinger. Se trata precisamente de un experimento mental formulado por Schrödinger para mostrar la situación paradójica a la que puede conducir la idea de la superposición de estados.

Un gato está dentro de una caja cerrada en cuyo interior hay un dispositivo que deja escapar un veneno en caso de que se produzca la desintegración de un átomo de material radioactivo (un fenómeno cuántico). La desintegración será detectada por un contador Geiger conectado a un martillo que romperá el tarro del veneno.

La probabilidad de que se produzca esa desintegración en un tiempo determinado sería del 50%. Mientras no abrimos la caja, el átomo está en una superposición de estados desintegrado/no-desintegrado y solo adquiere definitivamente una de estas dos condiciones una vez que la abrimos y, mediante esa acción, al observar el resultado, fijamos para siempre una de las dos posibilidades. Por la misma razón, el gato permanecería antes de que alguien lo observara en una superposición de estados vivo/muerto, puesto que su vida dependía del estado del átomo en cuestión, y sólo adquiriría uno de esos dos estados en el momento de la observación.

Probablemente a su pesar, Schrödinger tenía razón: las situaciones contraintuitivas que permite la mecánica cuántica no quedan confinadas al mundo microscópico, sino que pueden alcanzar al menos a ciertos niveles del macroscópico

Schrödinger quería poner de manifiesto con este experimento mental que las paradojas surgidas de las superposiciones de estados en los sistemas microfísicos no estaban confinadas en el ámbito atómico y subatómico, sino que podían ser trasladadas al ámbito macroscópico, donde el choque con el sentido común se hacía más inquietante y resultaba más patente, digámoslo así, lo absurdo de la interpretación propuesta sobre el problema de la medida.

El tiempo nos ha mostrado que aquello no resultó un mero juego intelectual. En la actualidad se han conseguido obtener “gatitos” de Schrödinger en el laboratorio. Son objetos que han sido puestos en una superposición de estados. En 1996 se consiguió hacerlo con un ión de berilio. Después se ha conseguido con moléculas cada vez más grandes. En 2019 se hizo con una molécula de oligoporfirina, que tiene más de 2000 átomos.

Más recientemente se ha logrado el entrelazamiento de estados en objetos macroscópicos, aunque de pequeño tamaño. El entrelazamiento es una superposición de estados que implica a dos o más sistemas cuánticos que han estado en interacción.

Todo esto sería la prueba de que, probablemente a su pesar, Schrödinger tenía razón: las situaciones contraintuitivas que permite la mecánica cuántica no quedan confinadas al mundo microscópico, sino que pueden alcanzar al menos a ciertos niveles del macroscópico. Él lo planteó como una forma de mostrar que la interpretación de Copenhague no podía ser correcta, pero lo que se ha visto es que en realidad no había nada absurdo o imposible en la situación (aunque eso no significa que la Interpretación de Copenhague sea la correcta).

Una de las explicaciones más aceptadas actualmente de por qué esto no se da en niveles mayores es la “decoherencia”. Según esta idea, la interacción con el entorno macroscópico, como sucede en un proceso de medición mediante un dispositivo experimental, rompe la coherencia de los estados cuánticos y destruye la manifestación de su superposición. Los estados clásicos (vivo o muerto) serían los más robustos en dicha interacción y son los que se manifiestan.

Como es fácil entender, el coste epistémico de aceptar todo esto es enorme, puesto que entonces habría que admitir que la teoría cuántica no habla sobre objetos y propiedades reales, sino solo sobre los resultados de nuestras mediciones, o más en concreto, sobre las probabilidades de obtener tales resultados si decidimos medir un sistema.

¿En qué consiste exactamente la interpretación de Copenhague?

Heisenberg y Bohr en 1934 Los defensores de la interpretación de Copenhague, aunque variaron en sus posiciones a lo largo del tiempo, se manifestaron en este sentido. Así, Heisenberg escribe:

“Las leyes naturales que se formulan matemáticamente en la teoría cuántica no se refieren ya a las partículas elementales en sí, sino a nuestro conocimiento de dichas partículas.”

Por su parte, Bohr mantuvo una posición no demasiado clara que sigue siendo hoy objeto de análisis, pero en cierto momento afirmó:

“No hay un mundo cuántico. Hay sólo abstractas descripciones físicas cuánticas. Es equivocado pensar que la tarea de la física es averiguar cómo es la naturaleza. La física se refiere a lo que nosotros podemos decir de ella”.

Pero precisemos en qué consiste la interpretación de Copenhague. Aunque es difícil señalar un conjunto definido de tesis como constitutivas de esta interpretación, dado que hubo más desacuerdos en puntos concretos de los que se dejaban traslucir, se puede decir que esta interpretación afianza las siguientes ideas, que desde entonces se convierten en la forma ortodoxa y casi general de entender la teoría cuántica:

- La función de onda es una herramienta de cálculo. Lo que el físico hace es construir una función de onda a partir de ciertas observaciones, y esa función es meramente un predictor de las probabilidades de los resultados de posteriores mediciones.

- El estado de un sistema entre dos observaciones no puede ser descrito. Carece de sentido en la teoría.

- Los conceptos clásicos (onda, corpúsculo, etc.) son imprescindibles en dicha descripción. Las descripciones en términos de onda y las descripciones en términos de partículas se refieren aspectos complementarios de los fenómenos microfísicos. Las “contradicciones” entre ambos aspectos son irreductibles (Principio de Complementariedad de Bohr).

- Los sistemas cuánticos tienen una naturaleza tanto ondulatoria como corpuscular, aunque la manifestación de una u otra dependerá del dispositivo experimental empleado en su medición.

- El colapso de la función de onda no es más que la determinación por parte del dispositivo de medida (debido a su carácter macroscópico) de uno de los posibles resultados de esa medida. Es la actualización de una potencialidad, en la explicación cuasi-aristotélica que ofrece Heisenberg.

- No puede trazarse una frontera precisa entre el dispositivo experimental y el sistema medido.

Piezas centrales de esta interpretación son los puntos 3 y 4, es decir, el Principio de Complementariedad y sus consecuencias. Los conceptos clásicos ondulatorios y corpusculares han de ser empleados en la explicación de los fenómenos cuánticos tal como nuestros instrumentos los detectan y miden, pero –y esto es lo decisivo– no son aplicables a los sistemas cuánticos en sí mismos, ya que, como señalamos antes, sobre determinadas características sólo se puede decir que adquieren “realidad” en el conjunto del dispositivo experimental, el cual solo permitirá medir un tipo de esas características en exclusión de otros.

Esta idea, unida a la interpretación probabilística de la función de onda que da Born, son los elementos que chocan más frontalmente con una interpretación realista de la teoría cuántica.

Esa es la razón principal por la que Einstein no aceptó ninguno de estos dos elementos. Sus convicciones realistas le llevaban a pensar que la mecánica cuántica, tal como estaba formulada, no podía ser la última palabra en la descripción de la naturaleza. Además, el papel que le concedía al azar, y, por tanto, su renuncia al determinismo, eran para él un motivo para creer que no era una teoría completa y que tarde o temprano sería sustituida por otra teoría que recuperara el determinismo y el realismo.

Einstein, siempre con lo real. Añadamos a esto que en ocasiones se incluye en la interpretación de Copenhague elementos que algunos de los propios artífices de la interpretación no aceptaron. En su obra Fundamentos matemáticos de la mecánica cuántica, publicada en 1932, John von Neumann proporcionó una formalización axiomática de la teoría e hizo una interpretación del problema de la medida que ejerció gran influencia. Consideraba necesario otorgar un papel destacado al observador en el acto de medición: el simple conocimiento por parte de un observador cambia el estado de un sistema físico.

Con ello, la mente del observador, incluso podría decirse que su mera consciencia, adquiere una función central en el proceso. Esto desviará la interpretación de la teoría hacia el idealismo. Bohr y sus seguidores no aceptaron nunca este papel decisivo de la consciencia. Para ellos, era el dispositivo experimental el que colapsaba la función de onda.

En esa misma obra, von Neumann ofreció una demostración, que todos aceptaron, de que no eran posibles teorías de “variables ocultas” en mecánica cuántica, es decir, teorías que pretendieran restaurar el determinismo y el realismo en la física bajo el supuesto de que la teoría no recogía todas las variables pertinentes. Esto se interpretó como un respaldo definitivo de la interpretación de Copenhague. Hoy sabemos que la pretendida demostración contenía un supuesto injustificado que la invalidaba, pues asumía de forma implícita que solo las teorías equivalentes a la formulación vigente de la mecánica cuántica eran aceptables.

Años después, en 1945, David Bohm pudo elaborar, de hecho, una teoría de variables ocultas. Feyerabend ponía este episodio como un ejemplo del modo en que el argumento de autoridad funciona en la ciencia. Sencillamente, muy pocos físicos eran capaces de entender plenamente la demostración, pero todos aceptaban la palabra de Bohr al respecto. La primera persona en darse cuenta del error, ya en 1935, fue una mujer, matemática y filósofa: Grete Hermann. Pero su artículo fue completamente ignorado. Era mujer, no era conocida y el artículo se publicó en una revista no muy relevante.

Hubo que esperar hasta 1966 a que John Bell mostrara de nuevo las deficiencias en la demostración de von Neumann. Si se hubiera atendido a la refutación de Hermann, la historia de las discusiones sobre los fundamentos de la teoría cuántica habría cambiado sustancialmente.

De hecho, en fecha tan temprana como 1927 ya se formuló una interpretación rival a la de Copenhague que chocaba con lo que von Neumann parecía haber demostrado. Louis de Broglie propuso en el V Congreso Solvay, celebrado ese año, una versión de la mecánica cuántica en la que el corpúsculo, identificado como una concentración de energía en una pequeña región de una onda, preserva su naturaleza clásica. Pero, a diferencia de las partículas clásicas, es guiado por una onda Ψ y, por tanto, está sujeto a los efectos de difracción.

Louis de Broglie y sus divertidísimos amigos charlando sobre lo real y lo irreal. La función de onda Ψ juega entonces un doble papel: es una onda de probabilidad, pero representa también una onda piloto que determina la trayectoria de la partícula en el espacio. En efecto, Ψ tiene el carácter de una representación subjetiva de las probabilidades construidas con la ayuda de una onda objetiva. La dualidad onda-partícula es reducida así por de Broglie a una síntesis onda-partícula: la realidad física no está constituida por ondas o por partículas, dependiendo del dispositivo experimental utilizado, sino por ondas y partículas conjuntamente.

La onda tendría una singularidad cuya trayectoria correspondería a la trayectoria de una partícula. La idea básica era similar a la que desarrollaría varios años después David Bohm. Sin embargo, de Broglie abandonó al año siguiente esta teoría debido a las críticas de von Neumann y otros, y se sumó a la interpretación de Copenhague.

El experimento EPR

En 1935, en colaboración con los jóvenes físicos Boris Podolsky y Nathan Rosen, Einstein presentó en un breve artículo de cuatro páginas un caso imaginario, conocido desde entonces como el experimento o la paradoja EPR (por las iniciales de sus apellidos), con el que se trataba de dejar en evidencia la incompletud de la mecánica cuántica. De acuerdo con los autores, una teoría es completa si "todo elemento de la realidad física" tiene una contrapartida en la teoría. Pero ¿cuándo estamos ante un "elemento de la realidad física"?

El artículo lo aclara:

“Si podemos predecir con certeza (i. e., con probabilidad igual a la unidad) el valor de una cantidad física sin perturbar el sistema de ningún modo, entonces existe un elemento de realidad física correspondiente a esa cantidad física”.

Dicho de otro modo, si es posible obtener el valor exacto de una propiedad sin tan siquiera intervenir sobre el sistema físico al que se le atribuye, cabe suponer que ello obedece a que en realidad el sistema tiene esa propiedad con ese valor, es decir, el valor viene dado por un estado físico realmente existente. Hay además una premisa fundamental para el argumento que es asumida a lo largo del artículo. Esa premisa se conoce como el "supuesto o principio de localidad".

Lo que afirma es que para dos sistemas que hayan interactuado en el pasado, ningún cambio que tenga lugar en uno de ellos después de que la interacción haya cesado puede ser consecuencia de un cambio en el otro.

El supuesto de localidad, o más bien su cuestionabilidad, se convertirá en un importante punto de discusión en el ulterior desarrollo del problema abierto por el artículo. El supuesto descarta la posibilidad de que la medición sobre un sistema ejerza alguna influencia instantánea sobre el otro sistema situado a distancia. Una vez separados, lo dos sistemas son independientes, a no ser, según Einstein y sus colaboradores, que estemos dispuestos a aceptar misteriosas acciones a distancia entre ellos.

Mediante el experimento mental que propusieron, intentaron probar que si se acepta la caracterización dada de la realidad física correspondiente a una magnitud física (junto con el supuesto de localidad), entonces la mecánica cuántica es incompleta, pues habría elementos de la realidad física sin una contrapartida en la teoría. Cabría esperar, pues, la formulación de una teoría mejor, que recogiera las variables que permanecían ocultas en la versión aceptada de la teoría (pese a lo que von Neumann había dicho) e hiciera desaparecer de este modo los problemas que suscitaba la interpretación de Copenhague.

Nunca una ciudad dio para tanto. (Lindsay Martin/Unsplash) El razonamiento era el siguiente:

Sea un sistema compuesto por dos partículas A y B que han estado interactuando en el tiempo y después han dejado de hacerlo. Se supone que se conoce el estado de las dos partículas antes de interactuar y, por tanto, se puede determinar (mediante la ecuación de Schrödinger) el estado del sistema compuesto por las dos partículas en cualquier tiempo posterior, incluso cuando ya no interactúan.

Si medimos ahora el momento de una de las partículas (digamos A) mediante el instrumental apropiado, podemos calcular con seguridad el momento de la partícula B sin tener que efectuar ninguna medición sobre ella. Asimismo, si en lugar del momento, decidimos medir la posición de A, podemos calcular la posición de B. Puesto que en ambos casos hemos podido establecer los valores de la posición y el momento de una de las partículas sin perturbarla en absoluto, hemos de aceptar que la partícula posee real y simultáneamente una posición y un momento con esos valores. Ahora bien, la mecánica cuántica no recoge esa posibilidad en su formalismo; por lo tanto, la mecánica cuántica es una teoría incompleta.

La réplica de Bohr fue inmediata. Apareció en el número siguiente de la Physical Review. Pero, desde luego, no fue muy clara, como era habitual en él, y más adelante admitió. Lo que hizo básicamente fue criticar el criterio de realidad que el artículo de EPR ofrecía y reafirmarse en la idea de que la única descripción posible es la del fenómeno cuántico, es decir, la totalidad de la situación experimental. No puede trazarse una distinción nítida entre el sistema medido y el dispositivo de medición. Esto era tanto como negarse a aceptar por principio la mera posibilidad experimental que el artículo describía.

Las desigualdades de Bell y el experimento de Aspect

En lo esencial, la discrepancia quedó en suspenso durante treinta años, hasta que en 1964 el físico irlandés John Bell, investigador del CERN, fue capaz de darle un giro inesperado a la situación y consiguió reavivar un debate que para muchos ya había sido cerrado en su momento en favor de las tesis de Bohr.

Bell desarrolló un teorema matemático, en la forma de una desigualdad, que abría la posibilidad de discriminar experimentalmente entre las propuestas de Bohr y las de Einstein. Representaba una diferencia cuantitativa susceptible de contrastación empírica entre la interpretación de Copenhague y la interpretación realista local de Einstein.

La desigualdad marcaba un límite estricto en el nivel de correlación esperable para los resultados de medidas simultáneas efectuadas sobre dos partículas que hubieran estado interactuando. Era una desigualdad que las mediciones de los fenómenos debían cumplir siempre de acuerdo con cualquier teoría realista local, pero que debían ser violadas en ciertas circunstancias de acuerdo con la interpretación de Copenhague. En la visión ortodoxa, el grado de correlación de los resultados de las mediciones debía sobrepasar el límite marcado por la desigualdad.

Aunque hubo intentos previos muy meritorios, los primeros en conseguir montar un experimento con las suficientes garantías para dilucidar esta cuestión fueron Alain Aspect y sus colaboradores del Instituto de Óptica de la Universidad de Paris. El experimento, publicado en 1982, consistía en una situación comparable a la descrita en el experimento EPR, aunque lo que se medía era el ángulo de polarización de dos fotones correlacionados emitidos por una fuente común.

El resultado fue que las desigualdades de Bell no se cumplieron en ese sistema. El realismo local de Einstein se veía así seriamente tocado, mientras que la interpretación de Copenhague salía reforzada de la prueba.

Desde la perspectiva actual, la interpretación realista local de Einstein, perfeccionada por Bell, ha sido descartada en los diversos experimentos posteriores. Algunos de estos experimentos no estaban exentos de complicaciones o de “lagunas”, pero fueron eliminadas posteriormente, de modo que se puede decir que el incumplimiento de las desigualdades de Bell por parte de los sistemas cuánticos ha quedado bien establecido.

Aunque no todos están de acuerdo acerca de las conclusiones correctas que sacar de estos experimentos, la no-localidad tiende a ser asumida como una característica fundamental del universo y cualquier interpretación realista tendría que incorporarla (como hace la de David Bohm). Al menos en el sentido de que el sistema que ha estado interactuando en el pasado será después un sistema no-separable. Es importante añadir que esa no-localidad no permite enviar señales a mayor velocidad que la luz, y, por tanto, las correlaciones cuánticas no chocan con la teoría de la relatividad einsteiniana.

La interpretación de los muchos mundos

Existe una interpretación alternativa a la de Copenhague que proporciona una visión diferente y sorprendente de lo que ocurre en la realidad. Dicha interpretación, conocida como la de "los muchos mundos". fue desarrollada en 1957 por Hugh Everett III en su tesis doctoral. Algunos la consideran una teoría, más que una mera interpretación, y, si bien no es la única alternativa ofrecida desde el realismo, sí es hoy la que más interés despierta.

Para entender su significado es útil recurrir a la interpretación que dio Bryce DeWitt de la paradoja de Schrödinger usando las ideas de Everett (aunque no contó con la aprobación del propio Everett). De acuerdo con esta interpretación, si miramos en la caja y encontramos que el gato está vivo, esta observación nos dice que ese es el resultado en nuestro universo, en el que el átomo radioactivo no se ha desintegrado, pero sabremos también en ese mismo instante, a partir de la aplicación del formalismo de la teoría, que hay un universo paralelo al nuestro en el que el observador (o sea, nosotros) encontrará que el gato está muerto, dado que en ese universo sí se habrá desintegrado el átomo.

¿Existe, no existe? Ah, si tan sólo lleváramos un siglo discutiéndolo. (Eric Han/Unsplash) Todo acto de medición de un sistema cuántico que esté en una superposición de dos estados bifurca, por tanto, el universo, y en cada uno de los universos resultantes, ambos reales, se ha obtenido uno de los dos resultados posibles. A nosotros nos parece que hay un solo universo en el que el gato está vivo, pero existe otro universo en el que el resultado que hemos obtenido no ha sido ese.

Nos parece que en cualquier proceso de medición un solo resultado de los posibles se ha hecho real, sin embargo, eso es una mera apariencia: todos los resultados posibles se han hecho reales, solo que en universos diferentes. No hay, por tanto, colapso de la función de onda causado por la medición. He aquí la clave. Esto, entre otras cosas, evita el problema de la medida e implica que el determinismo es restaurado en esta interpretación.

Si el problema de la interpretación de Copenhague era su coste epistémico, que obligaba a una posición fenomenista radical y hasta idealista, al aceptar la interpretación de los muchos mundos, el coste a pagar es el ontológico, y es un coste enorme.

Téngase en cuenta que, aunque el electrón (o cualquier sistema cuántico comparable) tendría una posición y velocidad definidas antes de la observación, todos los resultados posibles de la medición se darían en universos reales, solo que la medición obtenida en nuestro universo habría sido una concreta, mientras que en otro universo, al que no tenemos acceso, otro yo idéntico a mí, rodeado también de todos los demás seres humanos, de todas las estrellas, de todas las galaxias, habría obtenido otro resultado posible. En general, según algunos, cualquier transición cuántica, medida o no, generaría nuevos universos. Y es de suponer que en esos universos se estarían a su vez generando constantemente nuevos universos.

La interpretación de los muchos mundos ha recibido diversas críticas desde el punto de vista de su coherencia interpretativa. Se ha señalado, por ejemplo, que no puede explicar satisfactoriamente el papel de la probabilidad (si todos los resultados posibles son reales, si todos se cumplen y están regidos por una ecuación de onda determinista, ¿cómo hablar entonces de probabilidad?, ¿es solo como consecuencia de que no podemos tener consciencia más que de uno de los mundos?). Lo más inquietante, sin embargo, es que choca de forma evidente con el famoso principio de la navaja de Ockham. Ese de que no hay que multiplicar los entes sin necesidad. Tanto más cuanto que estos entes son mundos enteros de los que nada puede saberse.

Pese a todo, esta interpretación ha recibido un fuerte apoyo entre cosmólogos e investigadores en computación cuántica. Quizá algún día tengamos la posibilidad de realizar un experimento que permita dirimir si esta interpretación es preferible las otras, como pudo hacerse con la de EPR. Por el momento, sin embargo, no existe esa posibilidad, lo que ha hecho que se la acuse también de infalsabilidad. Pero esta acusación es injusta, puesto que se han imaginado experimentos que podrían cumplir esta función, solo que por el momento son irrealizables. Para que una hipótesis sea falsable basta con imaginar cómo falsarla, aunque no podamos llevar la falsación a la práctica.

En definitiva, la mejor teoría física que tenemos, la teoría cuántica, nos deja sin la más mínima posibilidad de dar una interpretación del mundo que sea manejable para el sentido común. Llega un momento en el que sólo las matemáticas pueden guiarnos, pero ni siquiera ellas nos pueden ofrecer una respuesta única.

En todo caso, el debate entre realistas y antirrealistas no está cerrado. No se puede decir que ningún bando haya obtenido la victoria definitiva. Por ello quizá no sea mala idea adoptar la posición que sugiere Adam Becker en las páginas finales de su excelente libro sobre los problemas filosóficos suscitadas por la teoría cuántica (p. 287):

“El pluralismo sobre las interpretaciones podría ser la respuesta correcta, de forma pragmática, mientras hacemos frente a este reto. O, si no el pluralismo, al menos la humildad. La física cuántica es al menos aproximadamente correcta. Hay algo real, ahí fuera, en el mundo, que de alguna manera se parece lo cuántico. Solo que no sabemos aún que significa esto. Y es el trabajo de la física averiguarlo”.

Dejemos, pues, que la física siga haciendo su trabajo. A buen seguro, la filosofía seguirá beneficiándose de ello.

Antonio Diéguez es Catedrático de Lógica y Filosofía de la Ciencia en la Universidad de Málaga y miembro de número de la Academia Malagueña de Ciencias. Sus líneas de investigación son el realismo científico, la filosofía de la biología, la filosofía de la tecnología, el biomejoramiento humano y el transhumanismo.

Es autor de numerosos artículos y libros. Entre estos últimos destacan: "La vida bajo escrutinio. Una introducción a la filosofía de la biología" (Biblioteca Buridán, 2012), "Filosofía de la ciencia" (UMAeditorial, 2020), "Transhumanismo. La búsqueda tecnológica del mejoramiento humano" (Herder, 2017), y "Cuerpos inadecuados" (Herder, 2021). -

La noticia El gran debate filosófico del siglo XX sigue abierto desde que Einstein rechazara el antirrealismo y la interpretación de Copenhague fue publicada originalmente en Xataka por Antonio Diéguez .